La matériel Nutanix, notions de base

La gamme Nutanix

[table id=5 /]

Dans un même cluster Nutanix vous pouvez mixer les briques et les nœuds. Tous ne doivent pas être identiques. C’est tout l’intérêt de la solution qui vous permet d’adapter la configuration de votre cluster pour que celle-ci puisse répondre à tous vos besoins.

Pour découvrir toute la gamme des serveurs brique Nutanix en français en détail, je vous invite à consulter le site officiel.

Prix d’une solution Nutanix

Bloc et nœud Nutanix

De façon générale et quel que soit le modèle de la gamme des Appliances Nutanix, on retrouve ce découpage :

- Le châssis du serveur dans un format 2U est appelé le Bloc.

- Un Bloc va pouvoir contenir entre 1 et 4 serveurs physiques. On les appelle les nœuds.

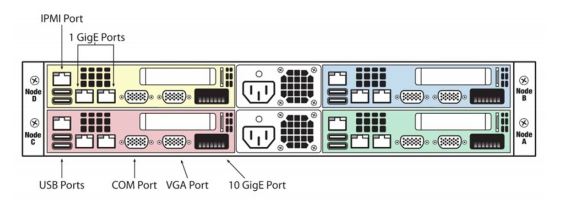

- Un nœud est composé de :

- Processeurs : souvent des biprocesseurs de marque Intel. Il n’y a pas de nœud avec des processeur AMD actuellement. Ces processeurs sont dotés d’un nombre cœur. Il faudra faire attention au nombre de cœur par processeur si vous devez licencier du Windows Server 2016.

- Mémoire : 32 Go est la quantité de RAM minimum et 512 le maximum. Cependant je vous conseille de choisir un nœud doté d’au moins 128 Go de RAM pour que l’intelligence décrite plus bas puisse fonctionner dans un contexte optimal.

- Stockage : le stockage de chaque nœud est composé entre 1 et 2 disques SSD pour la performance et entre 4 et 6 disque SATA pour l’espace de stockage.

- Réseau : le réseau est composé de plusieurs cartes 10 Gb.

- Administration : bien entendu vous pouvez prendre la main physiquement sur chaque nœud afin de forcer le redémarrage d’un serveur à l’aide d’une carte de management IPMI.

Important : Nutanix peut s’exécuter sur du matériel élaboré par d’autres constructeurs. Parmi eux, nous pouvons noter HPE, Dell ou QTC. La gamme présentée ci-dessus est celle des « Appliances » Nutanix. Ainsi il est possible en entreprise d’utiliser un autre matériel.

Nutanix Controler VM l’intelligence de Nutanix

Le Nutanix Controler VM est l’intelligence de la solution Nutanix. Celle-ci est appelée la CVM. La CVM est déployée sur tous les nœuds de tous les blocs. C’est la pierre angulaire de la solution Nutanix. En effet, cette machine virtuelle est responsable de la gestion du stockage entre l’ensemble des nœuds. Celui-ci est géré dans un mode Passthrough directement pour chaque hyperviseur déployé sur un nœud. Car même si Acropolis AVH est l’hyperviseur proposé nativement par Nutanix, il est possible d’en déployer un autre tel que Esx de Vmware ou Hyper-V de Microsoft par exemple.

Dans le cas d’un hyperviseur comme Esx le stockage est présenté comme une seule entité à l’aide du format NFS. Pour simplifier le stockage Nutanix serait vu comme une seule et même LUN si on essaie de la comparer à « l’ancienne technologie » des SAN. Toute l'administration se fait via Prism une interface conçue html 5.

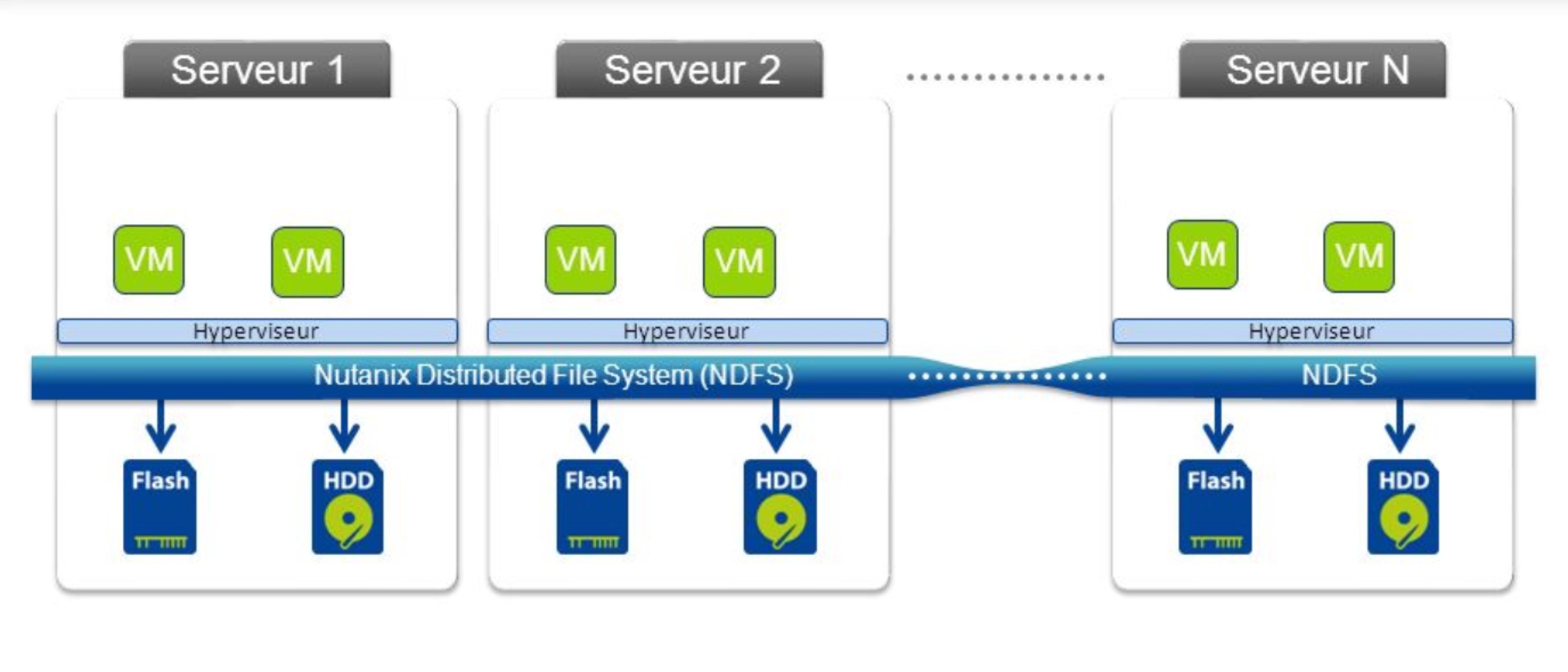

Nutanix Distributed File System, le système de fichier de Nutanix

La CVM présente le stockage de façon unifié aux hyperviseurs à l’aide de NDFS pour Nutanix Distributed File System. Ce système de fichier distribué n’est pas une exclusivité de Nutanix. En effet, celui-ci voit son origine dans les technologies de bigdata hadoop. C’est une sorte de dérivé des géants du Cloud Computinq que sont Amazon, Microsoft, Google mais également Facebook.

C’est la combinaison de la CVM et de NDFS qui donne à Nutanix une longueur d’avance à ses concurrents. En réussissant à proposer cette convergence de technologie au sein d’une même solution, les administrateurs IT vont pouvoir oublier la partie matérielle de la solution à administrer.

NDFS va être capable de gérer de façon efficace les différents types de disque dur SSD et SATA. Les CVM vont détecter chaque demande d’écriture ou de lecteur disque, les intercepter et répartir cela vers les autres CMV afin que les données soient écrites ou lues. Aussi la latence joue un rôle crucial dans ce type de technologie. Par conséquent, vous aurez bien compris que l’ensemble des nœuds doivent être connectés sur un réseau avec une très faible latence et avec un très haut débit. L’Ethernet 10 Gb a contribué à rendre cela possible.

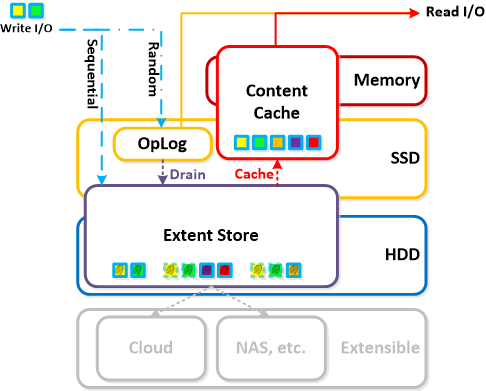

Gestion des I/O par Nutanix

La Gestion des I/O est assuré par chaque CVM. L’importance de cette machine ainsi que sa sollicitation permanente exige des ressources mémoires importantes. Aussi, je préconise de réserver 32 Go de RAM pour cette machine virtuelle (d’où la préconisation de 128 Go de RAM pour un nœud comme expliqué précédemment dans cet article).

La haute disponibilité des environnements Nutanix

La CVM va permettre aux environnements Nutanix de s’exécuter dans un environnement de très haute disponibilité.

RF2 ou RF3, la tolérance de panne Nutanix

Après avoir vu l’architecture physique des Appliances Nutanix et abordé les notions sur la gestion du stockage à l’aide de la CVM la gestion de la tolérance de panne se dessine. En effet c’est parce que Nutanix gère tous les accès disques à l’aide de sa CVM que la très haute disponibilité est possible et efficace.

On parle de RF (Replication Factor) pour spécifier le niveau de tolérance de panne implémenté.

- • RF 2 pour Replication Factor 2 signifie que les données sont copiées en deux exemplaires. Une sur le nœud actif et l’autre sur le nœud de votre cluster.

- • RF 3 pour Replication Factor 3 signifie que les données sont copiées en trois exemplaires. Une sur le nœud actif et deux autres copies sur deux autres nœuds de votre cluster.

Replication Factor et Hyperviseur

D’un point de vue de l’hyperviseur ces opérations sont totalement transparentes. En effet, c’est la CVM qui va présenter le stockage à l’hyperviseur. Ainsi celui-ci écrit et lit des données sans même savoir que celles-ci seront réparties sur différents nœuds. Ces opérations ne sont pas néfastes pour les performances puisque ces données écrites utilisent le cache et les disques en SSD. Ce n’est qu’une fois ces opérations validées qu’elles seront enregistrées sur les disques durs « classiques ».

Réplication Factor et le réseau

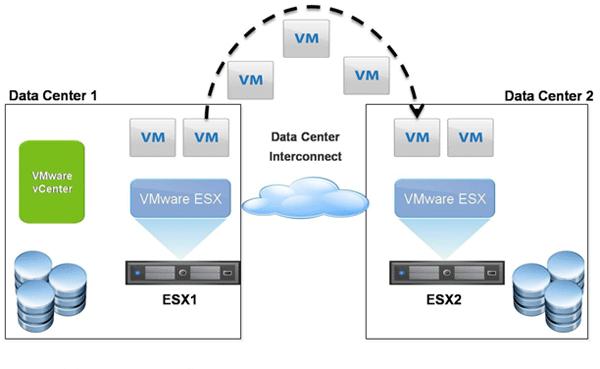

L’autre composant utilisé dans ce mécanisme de réplication inter nœud et le réseau. Celui-ci utilise les cartes réseaux en 10 Giga Bits pour faire transiter les données à écrire d’un nœud à l’autre. Ces nœuds étant locaux, la latence est faible. Aussi cette contrainte de latence est très importante et c’est pour cette raison que l’utilisation d’un Geo-Cluster Nutanix ne peut être réalisé uniquement lorsqu’ils sont proches. Cela ne limite pas l’utilisation d’un cluster en inter-lan mais juste la création d’un seul et même cluster réparti sur des sites géographiques très éloignés. Bien entendu on oublie l’utilisation d’une interconnexion de type VPN / Internet. Cependant il vous sera possible de répliquer avec un RTO relativement faible des VM hébergées sur différents physique et « mal » interconnecté.

Important : Nutanix utilise désormais le vocabulaire de Replication Factor contre celui de Fault Tolerance auparavant. Par exemple FT 1 équivaut à RF 2.

Le déplacement des VM à chaud avec Nutanix

En effet, lors du déplacement à chaud d’une machine virtuelle vers un autre hyperviseur, l’ensemble des requêtes en lecture seront exécutées en priorité localement sur le nouveau nœud choisi. Dans le cas où ces données ne sont pas présentes alors la CVM accédera de façon transparente à ce bloc de données hébergé sur le stockage local d’un autre nœud de votre cluster. La lecture du bloc se fait alors au travers du réseau dédié. Même si certaines configurations de la gamme Nutanix proposent un réseau 1G, dans les fermes hébergeant un nombre important de Vms c’est le réseau 10Gb qui doit être privilégié. Ces données seront ainsi copiées en locale et seront disponibles pour les demandes futures.

Important : Ces données sont recopiées même si elles sont déjà présentes sur d’autres nœuds conformément à la configuration de votre Replication Factor. Nutanix va toujours privilégier le stockage local des données sur l’hyperviseur qui héberge la VM. Les données sont ainsi en perpétuel mouvement. Encore une fois un réseau dédié en 10 Gb est à mon sens indispensable.

Perte d’un nœud Nutanix

La perte d’un nœud Nutanix revient à perdre l’hyperviseur. Cependant cela ne pose pas de soucis particulier. En effet on configure son cluster Nutanix en fonction d’un facteur de réplication qui est RF 2 au minimum soit la perte d’un nœud. Les données sont toujours disponibles sur au moins un autre nœud. La machine peut donc redémarrer sur un autre hyperviseur.

Lorsque le nœud d’origine est à nouveau en ligne alors les blocs modifiés sont de nouveaux synchronisés sur celui d’origine de façon transparente. La perte d’un ou plusieurs nœuds n’est donc pas problématique en soit. Cependant il faut prendre en considération la taille totale des VM puisque les données doivent bien entendu être répliquées à plusieurs endroits. Pour chaque niveau de RF on considère que le stockage nécessaire augmente d’environ 30%.

Pour garantir une nouvelle tolérance de panne, le CVM va écrire les données de la VM le stockage local du serveur puis choisira un autre nœud disponible dans votre cluster. Ces opérations garantissent ainsi la conservation du facteur de réplication et la protection des données même en cas de défaillance d’un nœud.

Important : Le redémarrage automatique de la VM est géré par la fonctionnalité de haute disponibilité de votre hyperviseur.

Perte de la CVM

Une des questions que l’on se pose dans ce type d’environnement est comment le système va continuer à fonctionner en cas de défaillance de la CVM ? Vous avez compris en parcourant cet article que la CVM est responsable de la présentation du stockage à l’hyperviseur. Nutanix incorpore une fonction d’autopathing ou de chemin automatique pour atteindre cet objectif.

En cas de perte de la CVM sur un serveur la fonction d’autopathing permettra d’aller chercher les données à un autre emplacement. Cette fonctionnalité est assurée à l’aide du DSF (Distributed Storage Fabric) réparti sur tous les nœuds de votre cluster.

Conclusion sur les notions de base de Nutanix

Pour conclure la lecture de cet article sur les notions de base d’une architecture Nutanix vous a permis de vous familiariser avec le jargon. Toutes les facettes n’ont pas été abordées et d’autres billets suivront. Cependant une bonne compréhension de la gamme, des briques et des blocs vous permettra d’appréhender une architecture Nutanix. L’intelligence implémenté dans la CMV permet d’accéder et présenter un stockage distribué sur le système de fichier NDFS. Enfin nous avons abordé les principaux composants pris en charge dans la haute disponibilité des VM hébergés dans un cluster Nutanix.